Siguiendo con la entrada anterior del blog en la que veíamos las principales características de la serie SRX de Juniper, hoy vamos a ver una de las muchas opciones de configuración que pueden soportar estos equipos. Concretamente vamos a realizar una configuración para crear un clúster entre 2 equipos Juniper SRX550 para garantizar la alta disponibilidad de una sede.

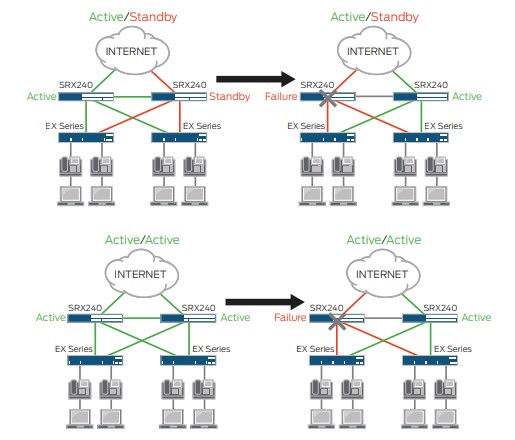

Una de las funcionalidades principales de la Serie SRX Branch de Juniper es la de firewall. Y como se puede observar en la siguiente imagen la de firewall en alta disponibilidad (HA). Dentro de la HA existen 2 modalidades:

– Activo/pasivo: Donde uno de los 2 firewalls es el principal y el otro esta inactivo observando al firewall principal para que en el caso de caída de este tenga que pasar a tener el rol de equipo principal

– Activo/activo: En este caso ambos equipos realizan las mismas funciones y existe un balanceo de tráfico. En caso de caída de uno de los 2 equipos, el equipo que permanece activo asumirá todo el tráfico

Para completar este articulo veremos la configuración básica para crear un cluster entre 2 equipos Juniper SRX550

Requerimientos para la creación de un cluster:

– Ambos equipos deben tener la misma configuración hardware. (show chassis hardware detail)

– Ambos equipos deben tener la misma versión de Junos (show version)

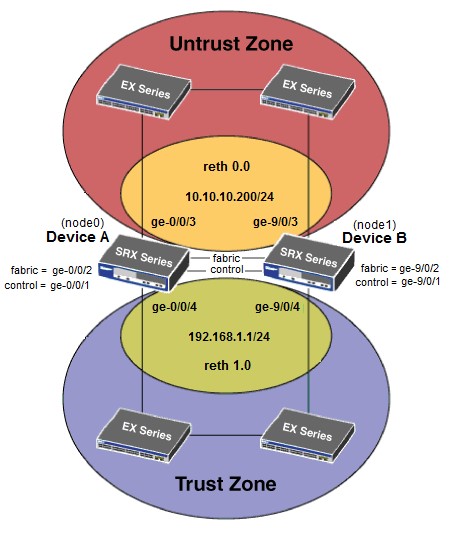

– Hay que borrar cualquier configuración existente en los interfaces que van a ser transformados en fxp0 (out-of band management) y fxp1 (control) cuando se activa el cluster. En los SRX550 estos interfaces son ge-0/0/0 para el fxp0 y el ge-0/0/1 para el fxp1

Pasos a realizar para la configuración del cluster en Juniper SRX550:

Paso 1. Conectar físicamente los equipos para establecer la comunicación de control y datos (fabric)

Link de control

En el equipo Juniper SRX550 conectar el interfaz ge-0/0/1 en el equipo A al interfaz ge-0/0/1 del equipo B. La interfaz ge-0/0/1 cambiará a la ge-9/0/1 después de activar el cluster en el paso 2.

Nota: Es recomendable de las interfaces de control se conecten directamente entre los equipos. Es importante evitar que se conecten a través de un switch.

Link de datos (fabric)

En el equipo Juniper SRX550 conetar el interfaz ge-0/0/2 en equipo A al interfaz ge-0/0/2 del equipo B. La interfaz ge-0/0/2 cambiará a la ge-9/0/2 después de activar el cluster en el paso 2.

Nota: Es recomendable que el link de datos se realice a través de puertos GE. No se pueden utilizar los puertos ge-0/0/0 ni ge-0/0/1

Paso 2. Habilitar el modo clustes y reiniciar los equipos

En el equipo A

set chassis cluster cluster-id 1 node 0 reboot

En el equipo B

set chassis cluster cluster-id 1 node 1 reboot

– El cluster ID debe ser el mismo en ambos equipos. Pero el node debe ser distinto

– El comando se debe ejecutar en ambos equipos

– El cluster ID deber ser mayor a 0. Si es 0 el cluster se encuentra deshabilitado

Los pasos del 3 al 8 pueden ejecutarse solo en el equipo A y se copiará automáticamente al equipo B

Paso 3. Configurar los datos específicos de cada equipo como son el hostname y la ip de gestión

set groups node0 system host-name equipoA

set groups node0 interfaces fxp0 unit 0 family inet address 192.168.10.1/24

set groups node1 system host-name equipoB

set groups node1 interfaces fxp0 unit 0 family inet address 192.168.10.2/24

set apply-groups “${node}”

Paso 4. Configurar los data link. En este ejemplo se usa el puerto ge-0/0/2 para cada nodo

set interfaces fab0 fabric-options member-interfaces ge-0/0/2

set interfaces fab1 fabric-options member-interfaces ge-9/0/2

Paso 5. Configurar el redundacy group 0 para las propiedades de failover del routing engine

set chassis cluster redundancy-group 0 node 0 priority 100

set chassis cluster redundancy-group 0 node 1 priority 1

set chassis cluster redundancy-group 1 node 0 priority 100

set chassis cluster redundancy-group 1 node 1 priority 1

Paso 6. Configurar la interfaz de monitorización. Monitorizar la salud de los interfaces es una manera para comprobar un fallo en el grupo de redundancia (Redundancy group)

set chassis cluster redundancy-group 1 interface-monitor ge-0/0/3 weight 255

set chassis cluster redundancy-group 1 interface-monitor ge-0/0/4 weight 255

set chassis cluster redundancy-group 1 interface-monitor ge-9/0/3 weight 255

set chassis cluster redundancy-group 1 interface-monitor ge-9/0/4 weight 255

Paso 7. Configurar las interfaces ethernet de redundancia (Reth interfaces) y asignarlas a una zona

set chassis cluster reth-count 2

set interfaces ge-0/0/4 gigether-options redundant-parent reth1

set interfaces ge-9/0/4 gigether-options redundant-parent reth1

set interfaces reth1 redundant-ether-options redundancy-group 1

set interfaces reth1 unit 0 family inet address 192.168.2.1/24

set interfaces ge-0/0/3 gigether-options redundant-parent reth0

set interfaces ge-9/0/3 gigether-options redundant-parent reth0

set interfaces reth0 redundant-ether-options redundancy-group 1

set interfaces reth0 unit 0 family inet address 10.10.10.200/24

set security zones security-zone untrust interfaces reth0.0

set security zones security-zone trust interfaces reth1.0

Paso 8. Realizar el commit. Los cambios se copiarán al equipo B

Commit

Para verificar el correcto funcionamiento del cluster podemos ejecutar los siguientes comandos

show chassis cluster status

show chassis cluster interfaces

show chassis cluster statistics

show chassis cluster control-plane statistics

show chassis cluster data-plane statistics

show chassis cluster status redundancy-group 1